High Performance Computing: Ohne Wakü ist die Leistung in Zukunft nicht mehr zu bändigen

Wenn knapp 1.000 Watt nur für die Lüfter in einem 6U-Server gebraucht werden, ist das Ende der Luftkühlung nah. Denn aktuell ist bei GPUs immerhin noch unter der 1.000-Watt-Marke Schluss, doch künftig fällt hier die Grenze von 1.500 Watt. Die Zukunft gehört der Wasserkühlung, auf der ISC 2024 ist sie omnipräsent.

Der Verbrauch auf selbem Raum steigt und steigt

Die Branche für Kühllösungen von Serversystemen boomt – erst recht, seit Nvidia im Bereich der GPUs explodiert ist. Denn all die fortschrittlichen Systeme mit stetig steigender Leistung benötigen nicht nur immer bessere Kühllösungen, sondern vor allem viel mehr davon. Ohne sie liegen große Teile der modernsten Technik nämlich an der kurzen (Watt-)Leine – und das wird nur noch schlimmer.

GPU-Beschleuniger sind dabei die treibende Kraft, CPUs aber direkt hinten dran. Ein Gefälle wird hier auch in Zukunft bestehen, aber beide zeigen steil ansteigende Trends. Während die CPUs und APUs von aktuell rund 350 bis 400 Watt in Richtung 500 bis 600 Watt schielen, gehen die GPUs von aktuell rund 700 Watt auf 1.200 bis sogar 1.500 Watt. Die 1.200 Watt sind für Nvidias Blackwell-GPU als wassergekühlte Lösung gesetzt, die Marke von 1.500 Watt wird von Intel für Falcon Shores vorgegeben. Gemäß den Gesprächen auf der ISC High Performance in Hamburg wird es von Intel eine luftgekühlte Variante, so wie sie noch von Gaudi3 existiert, bei Falcon Shores nicht geben. Intel geht All-in in der flüssigkeitsgekühlten Version und legt dafür die Spezifikation von 1.500 Watt fest.

15 kW in einem Server, 300 bis 500 kW pro Rack

Was das in Summe für ein System bedeutet, muss man sich vor Augen führen. Denn mit dem Stromverbrauch von GPU und CPU ist es in einem vollgepackten Server nicht getan, und die benötigen allein mit zwei CPUs plus acht GPUs schon an die 10 bis 12 kW. Weitere Komponenten im System, die wie allen voran die Netzwerk-Infrastruktur (Switch bis 200 Watt) ebenfalls benötigt werden, lassen schnell 15 kW Realität werden.

Mit einer Flüssigkeitskühlung schlägt man mehrere Fliegen mit einer Klappe und ist am Ende, zumindest wenn das System mehr als zwei Jahre im Einsatz ist, sogar noch günstiger, wenngleich das angesichts der hohen Auftaktkosten nicht gleich sichtbar ist. Die Flüssigkeitskühlung erlaubt den Betrieb schnellerer Hardware auf zugleich noch deutlich kleinerem Raum – die wassergekühlten HPE-Blades in kleinster Höhe für den neuen Supercomputer El Capitan zeigen das eindrucksvoll.

Bis zu 1 kW für die Luftkühlung

Am Ende müssen weniger Racks/Cabinets aufgestellt werden und die Leistung, die zugeführt wird, kommt auch für die Performance zum Einsatz und nicht, um damit Lüfter anzutreiben. Am Stand von Lenovo heißt es dazu beispielsweise: „Fans don't calculate“ – Lüfter bringen keine Rechenleistung. Im schlimmsten Fall fast 1 kW pro Blade daran zu verschwenden, viel kühlende Luft durchzupressen, ist nicht zielführend. Natürlich kostet die Infrastruktur für einen Wasserkühlungskreislauf beim Bau eines Datacenters entsprechend viel, doch lässt sie sich sehr schnell amortisieren, erklärt nicht nur Lenovo zur ISC 2024.

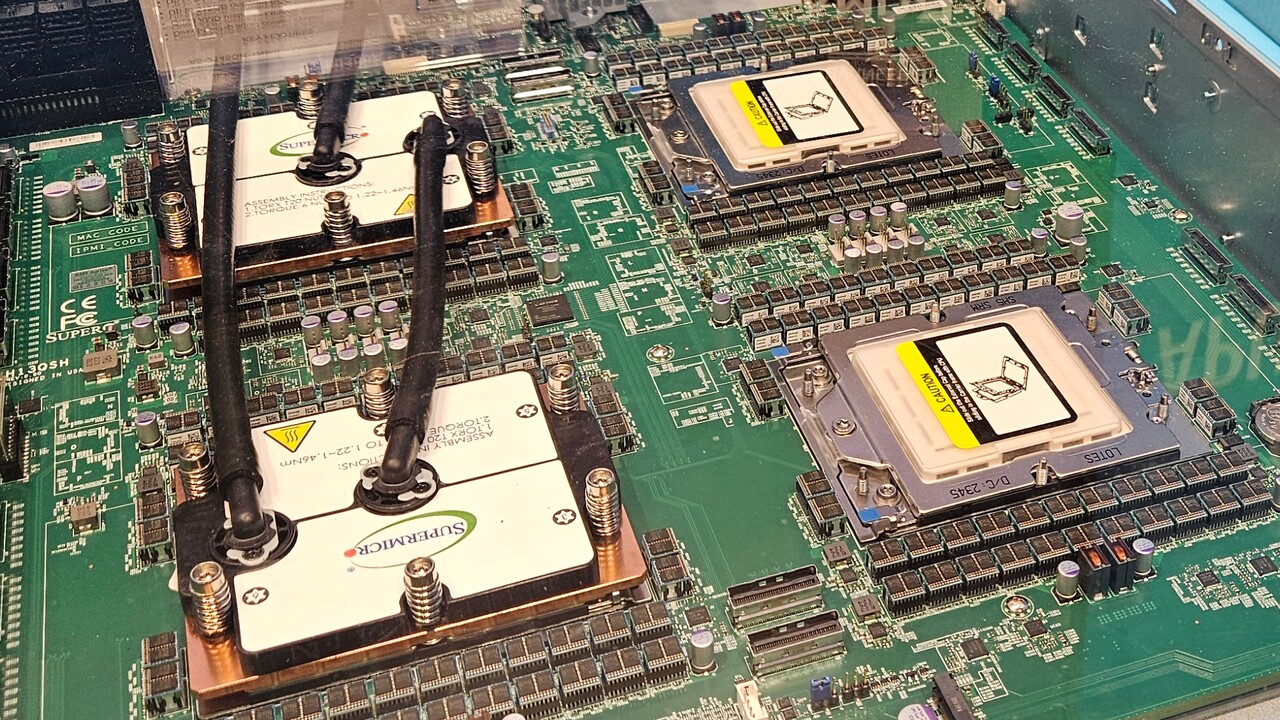

Plötzlich hat auch Supermicro das Thema deutlich mehr auf dem Schirm als noch vor einigen Jahren und baut nun ebenfalls eigene Lösungen in dem Bereich. Aktuell wird dabei noch auf Know-how von Drittfirmen zugegriffen. Das soll sich aber ganz schnell ändern und anschließend alles direkt von Supermicro kommen. Der Kunde soll jedoch bereits jetzt alles über Supermicro abwickeln können, falls Support benötigt wird.

Um ältere Supercomputer und Datacenter nachzurüsten oder auch gänzlich neue zu bauen, sind zudem Alternativen gefragt. Zur Messe gibt es deshalb viele Aufbauten, die eine Mischung aus Wasser und Luft anbieten. Das reicht für klassische Lösungen dann durchaus noch aus und erweist sich als effizient. DDC zeigt unter anderem seine Kombilösung für Racks mit bis zu 85 kW zu bändigen.

Nicht nur für die Kühlung ein Problem

Die Kühlung muss sich dem steigenden Stromverbrauch anpassen, aber das ist nicht einzige Konsequenz. Auf der Messe ist der steigende Stromverbrauch selbstverständlich insbesondere in Deutschland ein Aspekt, aber viele der Anbieter aus den USA können auch von dort interessante Dinge berichten.

Ist dort traditionell eher der Ansatz, dass der Strom doch eher aus der Dose kommt und man sich sonst weniger Gedanken macht, lassen die neuen großen Supercomputer aufhorchen. Für einen vollständigen Linpack-Run und eine Top-500-Einstufung (also absolute Volllast) sollte zur Sicherheit auch in den USA noch einmal vorab der Stromanbieter informiert werden, da sonst in Folge der kurzfristigen Last im Netz im Ort nebenan die Lichter ausgehen könnten, erklärten einige aus der Branche mit einem Lachen.

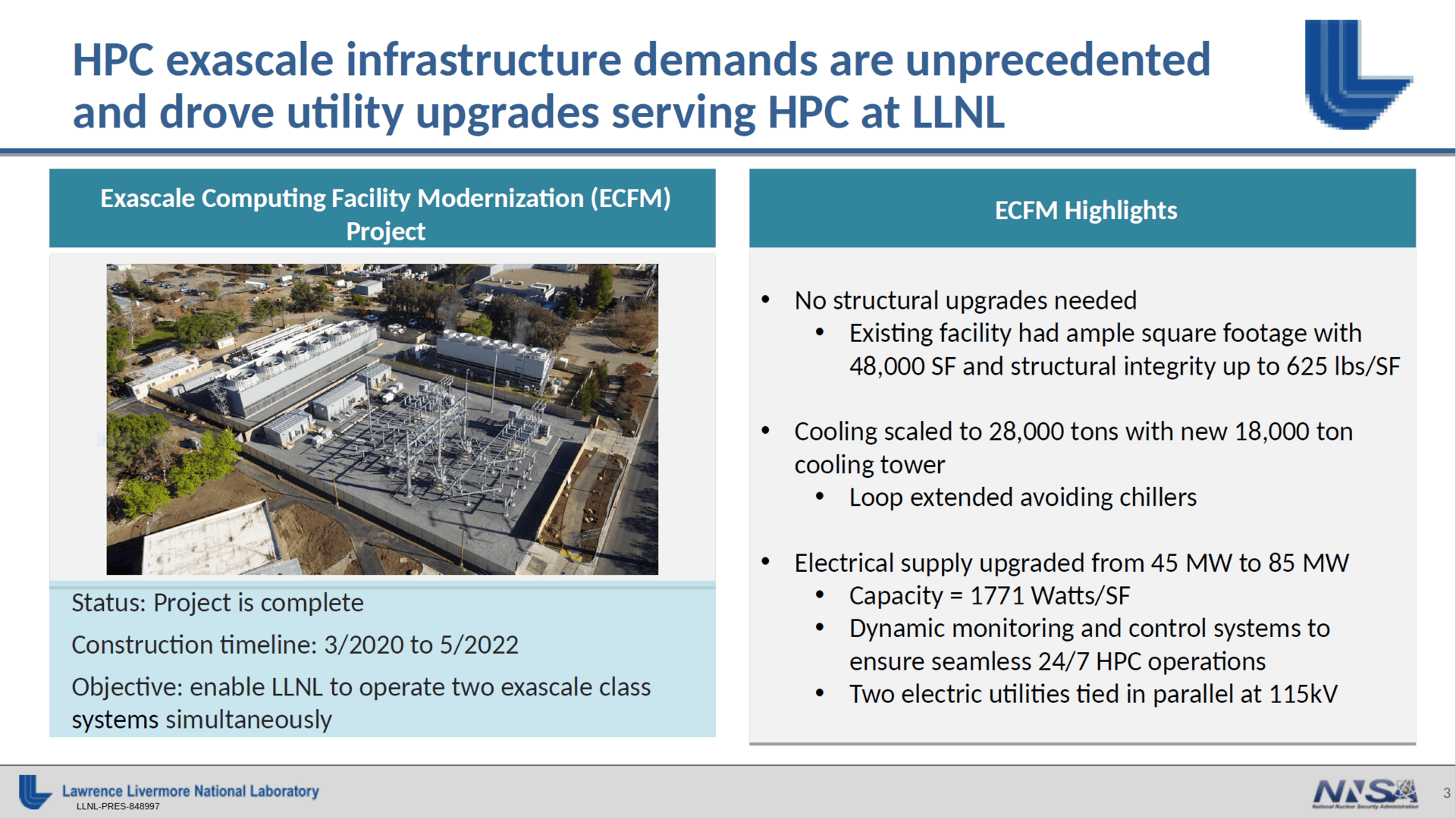

Der Blick in die Verbrauchsliste der Top 500 lässt daran wenig Zweifel aufkommen: Frontier auf Platz 1 verbraucht 22,8 Megawatt, Aurora auf Platz 2 sogar 38,7 Megawatt. Dass Deutschlands Exascale-System Jupiter am Ende nur bei rund 11 Megawatt herauskommen soll, liegt an der aktuell effizientesten Architektur in diesem Bereich rund um Nvidias Grace Hopper. El Capitan wird in der Spitze rund 35 Megawatt verbrauchen, die Infrastruktur wurde für bis zu 85 Megawatt ertüchtigt.

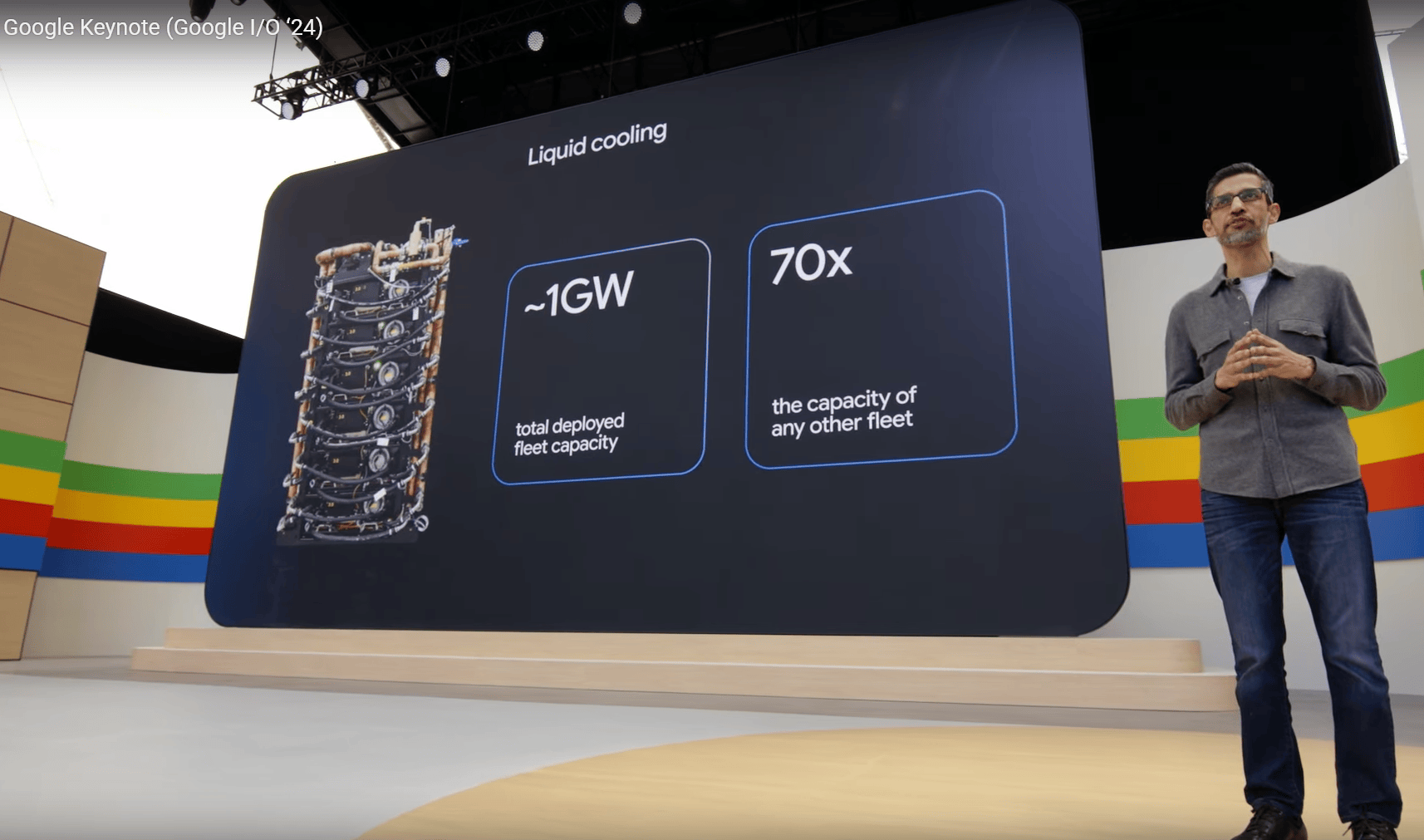

Von welchen Zahlen da gesprochen wird, macht Google zum parallel laufenden Kongress Google I/O 2024 ebenfalls klar. Das Unternehmen sei bereits auf dem Weg, Flüssigkeitskühlungen für rund 1 Gigawatt installiert zu haben – Tendenz steigend. Damit stellt sich der Konzern selbst als Vorreiter in dem Gebiet auf und verdeutlicht, wohin die Reise im Bereich moderne Datacenter und Supercomputer gehen wird.

Und Microsoft? Der Konzern hat in erster Linie in Folge der Generative-AI-Entwicklung (Training und Inferencing) seine CO2-Emissionen im letzten Jahr um 30 Prozent erhöht – das Ziel „Emission Zero“ zu werden, ist in weite Ferne gerückt.

In vielen Ländern oder auch Landesteilen ist die Infrastruktur vor allem bei der Energieversorgung dafür aber gar nicht ausgelegt. Hierzulande machten zuletzt bereits Stromengpässe für Eigenheimsiedlungen Schlagzeilen. Das Problem war nicht, dass es „zu wenig Strom gab“, aber die Infrastruktur zum Kunden gab dessen Durchleitung nicht her. Dass Brandenburg das nächste AWS-Datacenter bekommt, wird auch für den lokalen Netzbetreiber viel Arbeit und damit Investitionen bedeuten. Dafür den Rahmen zu bilden, ist auch Aufgabe der Politik – zumal die Netzbetreiber vieler Orts in kommunaler Hand sind. Ohne Strom geht auch in Zukunft nichts.

Dieser Artikel war interessant, hilfreich oder beides? Die Redaktion freut sich über jede Unterstützung durch ComputerBase Pro und deaktivierte Werbeblocker. Mehr zum Thema Anzeigen auf ComputerBase.